KI für Zeitreihen: Modelltypen (Teil 2)

aus der Reihe: “Die Evolution der Künstlichen Intelligenz für sequenzielle Daten”

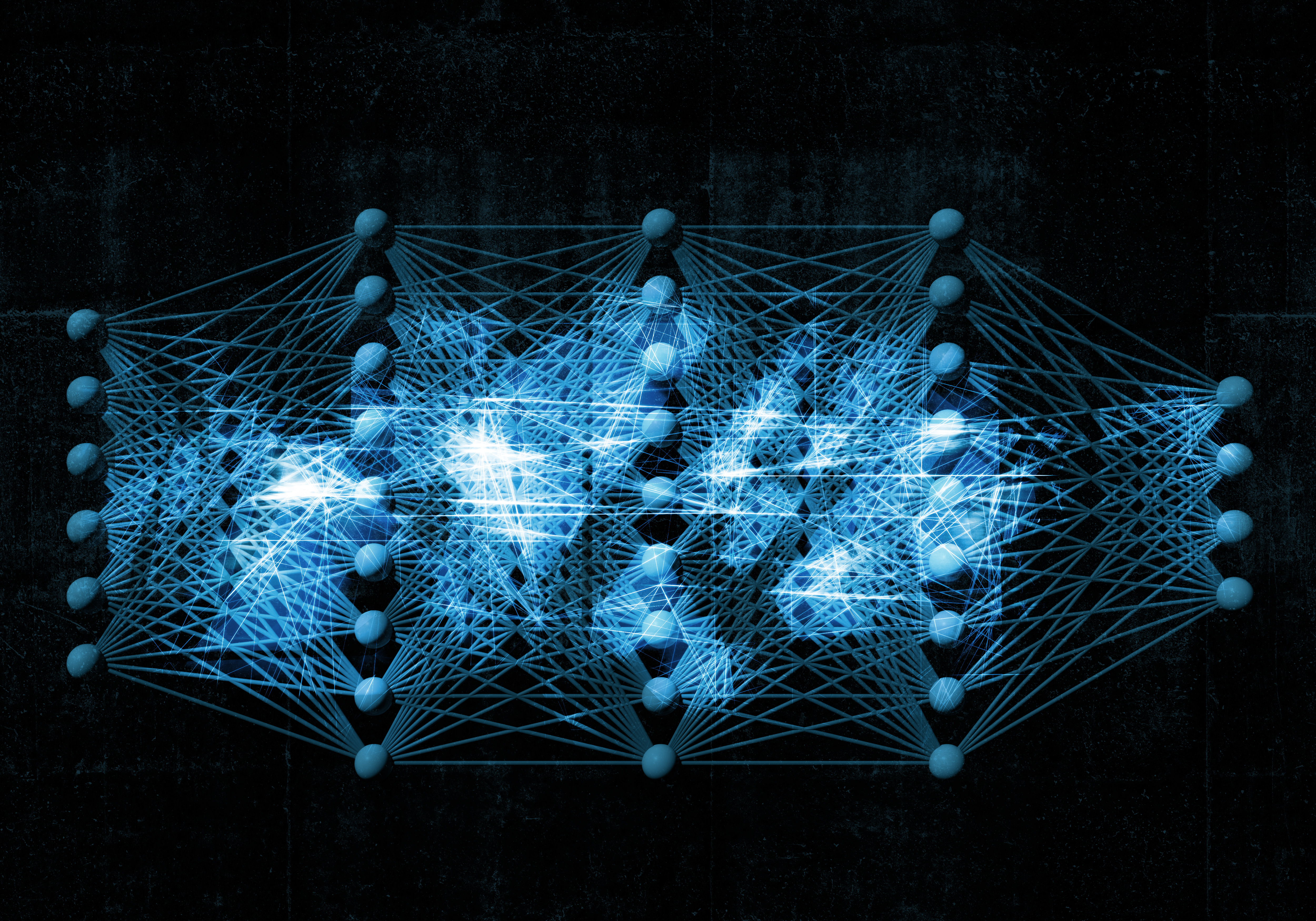

Nachdem wir uns in der ersten Folge zu den Modelltypen angesehen haben, wie (S)ARIMA-Modelle Vorhersagen mit Hilfe von Autokorrelation treffen, wollen wir uns als Nächstes mit neuronalen Netzen befassen.

Deep Learning mit neuronalen Netzen

Bei KI-Modellen in Form (künstlicher) neuronaler Netze findet die Berechnung von Vorhersagen nicht auf Basis ausgewählter statistischer Merkmale statt. Zwar greifen rekurrente neuronale Netze zur Vorhersage ebenfalls auf zurückliegende Werte zu, jedoch wird die Information aus weiter in der Vergangenheit liegenden Daten nur indirekt über einen internen Speicher, den hidden state, zum nächsten Neuron transportiert.

Wie sich der jeweils nächste Datenpunkt auf den Wert im Speicher auswirkt, ist dabei für alle Zeitschritte gleich und wird - wie ein Großteil des Verhaltens neuronaler Netze - durch Gewichte gesteuert. Andere Gewichte bestimmen, wie aus dem Speicher die Ausgabe erzeugt wird, beispielsweise die Vorhersage des nächsten Datenpunktes. Die Gewichte des Netzes sind auch hier das Ergebnis des Modelltrainings. Das Ziel dabei ist, solche Gewichte zu finden, welche die relevante Information in den Daten bestmöglich erfassen, um genaue Vorhersagen zu treffen.

Herausforderung 1: Langzeiteffekte

Da rekurrente neuronale Netze bei der Verarbeitung von Zeitreihen in eine lange Kette mehrerer Neuronen zerlegt werden, zählen sie zu den Methoden des Deep Learning. Diese Struktur macht sie einerseits vielseitig anwendbar, jedoch eignen sie sich trotz des Speichers nicht gut für lange Sequenzen. Je mehr Zeitschritte das Netz verarbeitet, desto länger wird die Kette an Berechnungen und desto weniger gelingt es, im Training die richtigen Gewichte zu finden, um den Einfluss weit zurückliegender Daten auf zukünftige Messwerte abzubilden.

Um langfristige Abhängigkeiten zu modellieren, wie sie in Zeitreihen häufig auftreten, wurde rekurrenten neuronalen Netzen ein Long Short-Term Memory hinzugefügt. Dieser Speicher kann selektiv aus den Eingabedaten lesen, gespeicherte Informationen behalten oder einen Teil vergessen, was die Berechnungsketten auf effektive Weise verkürzt.

Herausforderung 2: Interpretierbarkeit

Auf die Beispiel-Zeitreihe bezogen würde ein rekurrentes neuronales Netz im besten Fall lernen, zwischen den großen zyklischen Schwankungen und der zufälligen Abweichung aufeinanderfolgender Datenpunkte - dem “Rauschen” - zu unterscheiden. Verglichen mit einem (S)ARIMA-Modell hat es mehr Möglichkeiten, den Einfluss der vergangenen Werte zu beschreiben, sodass es komplexe Muster besser abbilden kann. Durch den verschachtelten Aufbau eines neuronalen Netzes lassen sich seine Gewichte allerdings nicht so explizit interpretieren wie die eines (S)ARIMA-Modells.

Häufig bleibt unklar, welche Eigenschaften in den Daten auf welche Weise zur Vorhersage beitragen, daher werden viele Deep-Learning-Modelle als black box aufgefasst, deren Innenleben verborgen bleibt. Die Verbesserung der Interpretierbarkeit ist ein Ziel aktueller wissenschaftlicher Untersuchungen und wird unter dem Begriff Explainable AI (xAI) durchgeführt.

Zusammengefasst:

- Rekurrente neuronale Netze sind Deep-Learning-Modelle, die Zusammenhänge in sequenziellen Daten erkennen und Vorhersagen auf Basis zurückliegender Werte treffen können.

- Das Training rekurrenter neuronaler Netze wird umso schwieriger, je mehr Zeitschritte verarbeitet werden. Langzeitabhängigkeiten können daher in der Regel nicht gut erfasst werden.

- Erweiterungen wie Long Short-Term Memory ermöglichen eine effektivere Verwendung relevanter Information und verbessern die Berücksichtigung von Langzeiteffekten.

- Deep-Learning-Modelle sind häufig black boxes in dem Sinn, dass sich anhand ihrer Gewichte nicht gut nachvollziehen lässt, wie eine Vorhersage zustande kommt. Daher ist es wichtig, die Zuverlässigkeit der Vorhersagen statistisch zu erfassen und kontinuierlich zu überwachen.